央视发表央视听媒体大模型 专攻视听媒体内容生产

7月23日消息,近日,在第二届全球媒体创新论坛上,上海人工智能实验室、央广电视总台联合发布“央视听媒体大模型”。

据新民晚报报道,本次发布的央视听大模型为首个专注于视听媒体内容生产的AI大模型,集合了央广电视总台的海量视听数据与上海AI实验室的原创先进算法、大模型训练基础设施优势。基于“书生通用大模型体系”,央视听大模型将拓展视听媒体的创意空间、提高创作效率并带来交互方式的变革。

据悉,以大模型的多模态理解、交互和生成能力为基础,媒体工作者将来有望在“聊天”中完成工作。目前,央视听大模型具备了强大的视频理解能力和视听媒体问答能力,AI相当于拥有了感知真实世界的“眼睛”和“耳朵”。

同时,央视听大模型可根据提供的视频,创作诸如主持词、新闻稿件,甚至诗歌等文字。媒体编辑可在大模型的协助下,一键为视频生成风格各异的解说词,当前生成内容已覆盖美食、文化和科技等多个领域。

央视听大模型可通过逐步呈现的视觉元素,理解并分析视频。用户通过与AI聊天对话的形式,深挖视频蕴含信息,进一步完善输出的内容——当它“看”到央视节目《中国诗词大会》中“看图猜诗词”环节视频,便可理解视频内容并生成出李白的《望庐山瀑布》。

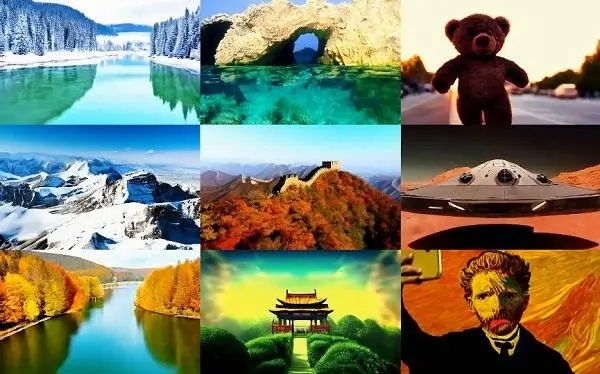

央视听大模型还为用户提供了强大的交互式图像、视频编辑与创作能力,使得新的内容生产方式变成可能。在央视听大模型的界面中,用户仅需使用简单的光标和文字指令,即可快速修改或编辑图像,实现“指哪改哪,画随口出”。

上海人工智能实验室科研团队介绍,央视听大模型具备的视觉理解能力,源于跨模态互动技术的最新突破,将图像/视频视为另一种“语言”,并将视觉与语言对齐,降低人工智能视觉任务的门槛。基于对多模态数据的建模,央视听大模型可感知图像的风格与纹理笔触,通过将用户输入的文本指令与图像对齐,实现按照用户需求生成画面及风格一致的其他内容。

除了视频内容,央视听大模型还具备快速生成“数字人主播”的能力。使用较短的真人采集视频即可生成对应的数字人。AI生成的数字人主播以“真人”形象呈现,不仅能根据既定文案和背景场景快速生成播报视频,还可自动学习真人的语言及动作习惯,做到形象更逼真,表情更自然。