百川智能2代开源大模型亮相,王小川:文理兼备,已超越LLaMA 2

9月7日消息,从去年12月ChatGPT的浪潮席卷全球以来,几乎所有的科技企业都想抓住这个机会。经过大半年的沸腾后,大模型行业出现了一股新的浪潮:从闭源到开源。

LLaMA2发布于今年7月19日,由美国互联网大厂Meta推出,当时在全球引起轰动,外界评价说,LLaMA2的开源将可能影响大模型最终格局。而在百川智能创始人兼CEO王小川看来,全新发布的Baichuan 2系列开源大模型,已经全面超越了LLaMA2的性能。

摄

北京时间9月6日,百川智能召开主题为“百川汇海,开源共赢”的大模型发布会。会上,百川智能宣布正式开源微调后的Baichuan2-7B、Baichuan2-13B、Baichuan2-13B-Chat与其4bit量化版本,并且均为免费可商用。

同为大模型创业者的澜舟科技创始人兼CEO周明现身百川智能发布会,周明表示,国外开源模型更多是支持英文为主的西方语言,对中文的支持要么不足,要么不太友好。而Baichuan2两款模型对中文用户的支持非常友好,并且在性能方面都超越了英文同等尺寸模型,因此是对中国大模型领域研究和应用的利好消息。

今年4月,王小川在离开搜狗一年半后创办了百川智能,这个成立不到半年的公司对大模型产业发展会产生哪些影响,引起了各界不小的关注。

文理兼备,性能超越LLaMA2

据了解,在新的模型上,百川智能的研究者们从数据获取到微调进行了很多优化。

Baichuan2-7B-Base和Baichuan2-13B-Base,均基于2.6万亿高质量多语言数据进行训练,在保留了上一代开源模型的生成与创作能力,多轮对话能力以及部署门槛较低等众多特性的基础上,两个模型在数学、代码、安全、逻辑推理、语义理解等能力有显著提升。其中Baichuan2-13B-Base相比上一代13B模型,数学能力提升49%,代码能力提升46%,安全能力提升37%,逻辑推理能力提升25%,语义理解能力提升15%。

摄

“我们借鉴了之前做搜索时的更多经验,对大量模型训练数据进行了多粒度内容质量打分,使用了 2.6 亿 T 的语料级来训练 7B 与 13B 的模型,并且加入了多语言的支持。”王小川表示,“我们在千卡 A800 集群里可以达到 180TFLOPS 的训练性能,机器利用率超过 50%。在此之外,我们也完成了很多安全对齐的工作。”

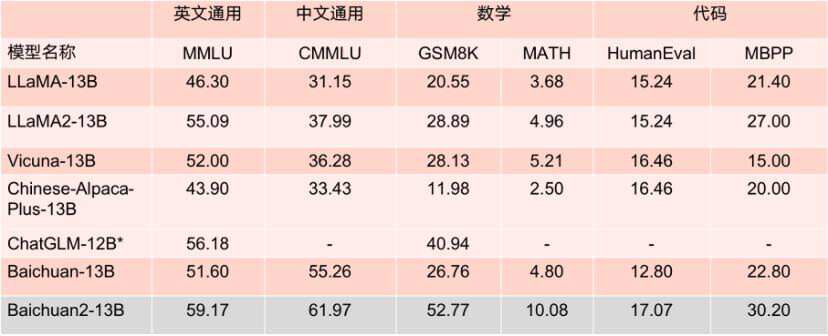

本次开源的两个模型在各大评测榜单上的表现优秀,在 MMLU、CMMLU、GSM8K 等几大权威评估基准中。以较大优势领先 LLaMA2,相比其他同等参数量大模型,表现也十分亮眼,性能大幅度优于 LLaMA2 等同尺寸模型竞品。

更值得一提的是,根据 MMLU 等多个权威英文评估基准评分 Baichuan2-7B 以 70 亿的参数在英文主流任务上与 130 亿参数量的 LLaMA2 持平。

百川供图

值得一提的是,根据MMLU等多个权威英文评估基准评分Baichuan2-7B以70亿的参数在英文主流任务上与130亿参数量的LLaMA2持平。

7B参数模型的Benchmark成绩 百川供图

13B参数模型的Benchmark成绩 百川供图

Baichuan2-7B和Baichuan2-13B不仅对学术研究完全开放,开发者也仅需邮件申请获得官方商用许可后,即可以免费商用。

全程开源模型训练Check Point,助力学术研究

大模型训练包含海量高质量数据获取、大规模训练集群稳定训练、模型算法调优等多个环节。每个环节都需要大量人才、算力等资源的投入,从零到一完整训练一个模型的高昂成本,阻碍了学术界对大模型训练的深入研究。

本着协作和持续改进的精神,百川智能本次开源了模型训练从220B到2640B全过程的 Check Ponit。这对于科研机构研究大模型训练过程、模型继续训练和模型的价值观对齐等极具价值,将极大推动国内大模型的科研进展,开源训练模型过程对国内开源生态尚属首次。

百川供图

值得一提的是,在大会现场,中国科学院院士、清华大学人工智能研究院名誉院长张钹对大模型发展提出了自己的看法。张钹认为,虽然大模型行业取得了广泛关注,但是“大模型产生”的现象仍然缺乏可解释性。

到现在为止,全世界对大模型的理论工作原理、所产生的现象都是一头雾水,所有的结论都推导产生了「涌现现象」,所谓「涌现」,就是给自己一个退路,解释不清楚的情况下就说它是涌现,实际上这反映了我们对它一点不清楚。

张钹表示,对于模型的训练与推理的过程,仍然是人工智能学术领域需要不断去探索的课题。到现在为止国内的大模型主要集中在垂直领域的应用上,因此,他很支持百川智能把这次的开源模型定位在助力学术研究上。

张钹院士 百川供图

技术报告揭示训练细节,繁荣开源生态

当前大部分开源模型在开源过程中只是对外公开自身的模型权重,很少提及训练细节,企业、研究机构、开发者们只能在开源模型的基础上做有限的微调,很难进行深入研究。

百川智能在发布会上宣布,公开Baichuan 2的技术报告。技术报告将详细介绍Baichuan 2 训练的全过程,包括数据处理、模型结构优化、Scaling law、过程指标等。

王小川表示,“这对于大家理解预训练,或者进行微调强化能够带来帮助。这也是在国内首次有公司能开放这样的训练过程。”

百川供图

百川智能自成立之初,就将通过开源方式助力中国大模型生态繁荣作为公司的重要发展方向。成立不到四个月,便相继发布了 Baichuan-7B、Baichuan-13B 两款开源免费可商用的中文大模型,以及一款搜索增强大模型 Baichuan-53B,两款开源大模型在多个权威评测榜单均名列前茅,目前下载量超过 500 万次。

不仅如此,在今年创立的大模型公司中,百川智能是唯一一家通过《生成式人工智能服务管理暂行办法》备案,可以正式面向公众提供服务的企业。凭借行业领先的基础大模型研发和创新能力,此次开源的两款Baichuan 2大模型,得到了上下游企业的积极响应,腾讯云、阿里云、火山方舟、华为、联发科等众多企业均参加了本次发布会并与百川智能达成了合作。

未来,百川智能将在开源大模型领域持续深耕,将更多的技术能力、前沿创新开放出来,与更多的合作伙伴们共同助力中国大模型生态发展。