hadoop前期环境搭建

主机名 ip ssh免密登陆

#修改主机名

hostnamectl set-hostname node1

#修改ip地址

vim /etc/sysconfig/network-scripts/ifcfg-ens33

#node1

IPADDR="192.168.88.101"

NETMASK="225.225.225.0"

GATEWAY="192.168.88.2"

DNS1="192.168.88.2"

#重启网卡

systemctl stop network

systemctl start network

#或者直接

systemctl restart network

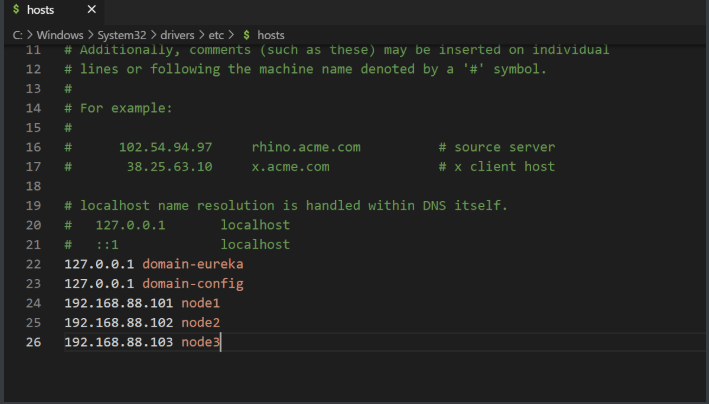

配置主机名映射

#linux中修改hosts

# vim /etc/hosts

192.168.88.101 node1

192.168.88.102 node2

192.168.88.103 node3

配置ssh免密登陆

#生成ssh密钥 一直enter

ssh-keygen -t rsa -b 4096

#进入生成的ssh密钥文件夹

cd .ssh/

#设置自己免密登陆

ssh-copy-id node1

#ssh免密登陆node1

ssh node1

#

后面的大数据软件不会用root用户启动(安全)

#现在为每台机器 创建一个单独的hadoop用户,并为三台服务器同样配置hadoop用户的免密互通

#创建hadoop用户

useradd hadoop

#设置用户密码 123456

passwd hadoop

#在每台机器切换带hadoop用户

su - hadoop

#执行 创建ssh密钥

ssh-keygen-t rsa -b 4096

#在每台机器都执行 免密 (切换用户喔)

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node3

Jdk环境部署

#1.创建文件夹()用来部署jdk

mkdir -p /export/server

#使用rz命令上传

#2,解压jdk 安装文件

tar -zxvf jdk-8u361-linux-x64.tar.gz -C /export/server/

#cd进入/export/server/ 查看当前目录 ll命令

#3.配置jdk软链接

ln -s /export/server/jdk1.8.0_361/ jdk#名为jdk

#查看

ls -l;

#4.配置JAVA_HOME环境变量

vim /etc/profile#编辑这个文件

#在end加入下main下面

export JAVA_HOME=/export/server/jdk

export PATH=$PATH:$JAVA_HOME/bin

#5.让环境变量生效

source /etc/profile

#6.配置Java执行程序的软链接

rm -f /usr/bin/java#删除系统自带的java程序

ln -s /export/server/jdk/bin/java /usr/bin/java#软连接我们自己安装的Java程序

#7.执行验证

Java -version

node2通过node1远程复制文件夹

scp -r jdk1.8.0_361 node2:`pwd`/

防火墙,SELinux,时间同步等系统配置

#关闭防火墙(每台都执行)

systemctl stop firewalld

systemctl disable firewalld

#SElinux安全模块

vim /etc/sysconfig/selinux

SELINUX=disabled#保存退出,重启虚拟机,不要把disabled单词写错,不然无法启动系统

init 0 或者init 6 #重启系统

#查看防火墙的状态

systemctl status firewalld

修改时区并配置自动同步

#1.安装ntp软件

yum install -y ntp

date#查看时间

#2.删除系统自带的 软连接上海的

rm -f /etc/localtime

ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

#3. 通过阿里云矫正

ntpdate -u ntp.aliyun.com

#4.设置开机自动校正

systemctl start ntpd

systemctl enable ntpd#设置开机自启

systemctl status ntpd#查看状态